內部連結 - Internal Links

內部連結是指向(目標)與連結所在的網址(來源)皆是相同網址,簡單的說,內部連結就是同一網站的另一個網頁。

程式範例

最佳格式

在連結文字中使用描述性的關鍵字,以便了解來源網頁,有嘗試說明主題或關鍵字。

什麼是內部連結?

內部連結是從一個網址的一個網頁連接到同一個網址上的不同網頁的連結,它們最常用於主選單上。

這些類型的連結分別為三種原因:

-

他們允許訪客在網站內瀏覽。

-

他們用來幫助網站建立訊息的層級。

-

他們幫助傳遞網站權重(排名權)保留在網站內。

SEO的最佳做法

對於建立網站架構和傳遞連結權重來說,內部連結是最有用的(對外連結也是不可少的),以這個因素來說,要建立一個SEO友善的網站,網站架構與內部連結是很重要的。

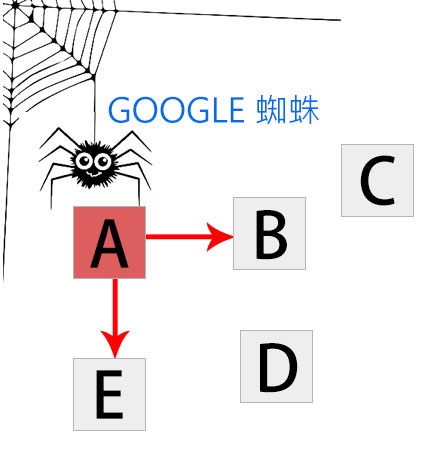

在一個獨立的網頁上,搜尋引擎需要查看網頁內容,以方便在大量的關鍵字索引中,列出結果網頁,他們還需要訪問可抓取的連結結構(一種讓蜘蛛瀏覽網站路徑的結構)以查詢網站上的所有網頁,(要查看您網站的連結結構,請嘗試通過Open Site Explorer執行您的網站),成千上萬的網站以搜尋引擎無法訪問的方式隱藏或掩蓋其主要導覽連結,這是個嚴重錯誤,這阻礙搜尋蜘蛛將網頁列入搜尋引擎索引的能力,下面是如何解決這個問題的範例:

在上面的例子中,Google的蜘蛛已經到達網頁“A”,並且看到網頁“B”和“E”的內部連結,不過C和D可能是網站的重要網頁,但是蜘蛛沒有辦法到達那裏,甚至雖然知道他們存在,但是因為沒有可供抓取的連結,所以無法前往這些網頁,就Google而言,這些網頁基本上就代表不存在,如果蜘蛛無法到達這些網頁,那麼有再好的內容、再好的關鍵字SEO,與再聰明的行銷策略是完全沒有意義的。

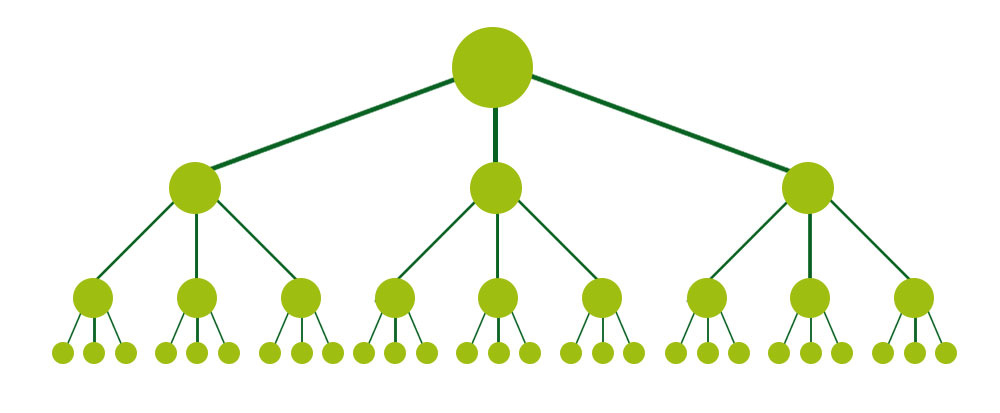

一個網站的最佳結構看起來類似於一個金字塔(頂部的大點是首頁):

該結構在首頁和任何特定網頁之間,如果是最小可能的連結次數,這對SEO是有幫助的,因為它允許連結權重(排名能力)經過整個網站,進而增加了每個網頁的排名潛力,這種結構在許多高性能網站(如Amazon.com)上以類別和子類別系統的形式很常見。

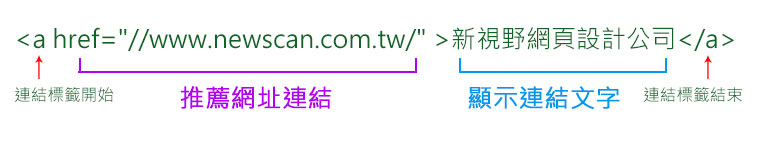

但是這是如何完成的呢?最好的方法是使用內部連結和補充URL結構,例如,他們在內部連結到位於http://www.example.com/mammals的頁面,並帶有文字“cats”的連結,以下是格式正確的內部連結格式,想像一下這個連結在網址名稱www.newscan.com.tw上。

在上圖中,“a”標籤指示連結的開始,連結標籤可以包含圖片,文字或其他對象,所有這些都可以在網頁上提供一個“可以點擊的”區域,訪客可以通過該區域移動到另一個網頁,這就是網際網路的原始概念:“超連結”,連結引用位置告訴瀏覽器和搜尋引擎連結指向的地方,在這個例子中,引用了URL https://www.newscan.com.tw,接下來,訪問者連結的可見部分在SEO世界中被稱為“錨點文字”,描述連結指向的網頁,在這個例子中,指向的網頁是關於新視野網頁設計公司的網頁設計商品,因此連結使用錨點文字為“新野網頁設計公司”,標籤會關閉連結,以防止標籤後的其它元素不會將連結屬性套用到它們。

對於搜尋引擎來說「連結」是一種很顯著可以理解的基本規則,搜尋引擎蜘蛛他們大部分會將這個連結添加到網站的引擎連結圖中,用它來計算查詢獨立變數(如MozRank),並按照它來索引並且引用網頁的內容。

以下是網頁可能無法被訪問到的常見原因,可能因此而無法被索引。

表格欄位下方的“送出“連結

表單可以包含基本的元素,如下拉選單或像完整的問券調查那樣複雜的元素,無論哪種情況,搜尋蜘蛛都不會去嘗試“送出”表單,因此通過表單可以訪問的任何內容或連結對引擎而言都是看不見的。

無法透過網站“搜尋欄位“建立索引

蜘蛛不會嘗試執行搜尋來查找內容,因此估計數百萬的網頁隱藏在完全無法訪問的內部搜尋欄位的背後。

無法解析的Javascript中的連結

使用JavaScript建置的連結有可能不好的,是有可能大大降低網頁的呈現機會,不過似乎Google似乎已經克付了這個問題。

Flash,Java或其他UI中的連結

連結引擎通常無法訪問嵌入在Flash,Java小程序和其他UI中的任何連結。

連結指向由Meta Robots Tag或Robots.txt阻止的頁面

Meta Robots標籤和robots.txt文件都允許網站所有者限制蜘蛛對網頁的訪問。

同一個網頁上具有數百或數千個連結

搜尋引擎都有一個基本的抓取限制,每頁150個連結,之後他們可能會停止從原始網頁連結到其他的網頁,這個限制是有一定的靈活性的,特別重要的網頁可能會有200甚至250個連結,但是在一般情況下,將頁面上的連結數量限制在150以內較為恰當。

Frames或是IFrames內的連結

在技術上,兩個Frames和IFrames中的連結都是可以抓取的,但是從架構和追蹤兩個層面來看,這兩種Frames都呈現結構性問題,只有具有高技術的工程師才能使用這些元素結合內部連結來讓搜尋引擎索引和連結。

避免了這些陷阱,網站管理員可以有乾淨,可以讓蜘蛛抓取的HTML連結,允許蜘蛛輕鬆訪問他們的網頁內容,連結可以應用其他屬性,除了rel = "nofollow "標籤之外,引擎幾乎忽略所有其他屬性。

想快速瀏覽一下您的網站的索引?,可以使用「Open Site Explorer」「Screaming Frog」 來抓取你的網站,然後比較您在Google上執行網站搜尋時抓取的網頁數量與列出的網頁數量。

rel = "nofollow "可以使用以下語法:

在這個例子中,通過將rel = "nofollow "屬性添加到連結標籤,網站管理員告訴搜尋引擎,他們不希望這個連結被解釋為正常的權重傳遞,“群眾投票”,Nofollow是用來阻止自動部落格討論,留言版和連結導入垃圾郵件的方法,但隨著時間的推移,這種方法已經演變成告訴引擎,需要削弱通過連結權重的方式,但是每個引擎對於nofollow標籤的連結都有些微不同解釋。

資料來源:https://moz.com/learn/seo/internal-link

歡迎推廣本文,請務必連結(LINK)本文出處:新視野網頁設計公司